ChatGLM3:智谱AI和清华大学KEG实验室联合发布新一代对话预训练模型

扫地升 2023-10-28 21:22:17 浏览:455

本文来源于微信公众号“ NLP工程化”,作者:扫地升

ChatGLM3-6B是ChatGLM系列最新一代的开源模型,在保留了前两代模型对话流畅、部署门槛低等众多优秀特性的基础上,ChatGLM3-6B引入了如下特性:

更强大的基础模型:ChatGLM3-6B的基础模型ChatGLM3-6B-Base采用了更多样的训练数据、更充分的训练步数和更合理的训练策略。在语义、数学、推理、代码、知识等不同角度的数据集上测评显示,ChatGLM3-6B-Base具有在10B以下的预训练模型中最强的性能。 更完整的功能支持:ChatGLM3-6B采用了全新设计的Prompt格式,除正常的多轮对话外。同时原生支持工具调用(FunctionCall)、代码执行(CodeInterpreter)和Agent任务等复杂场景。 更全面的开源序列:除了对话模型ChatGLM3-6B外,还开源了基础模型ChatGLM-6B-Base、长文本对话模型ChatGLM3-6B-32K。以上所有权重对学术研究完全开放,在填写问卷进行登记后亦允许免费商业使用。

软件依赖如下所示:

pip install protobuf transformers==4.30.2 cpm_kernels torch>=2.0 gradio mdtex2html sentencepiece accelerate

可以通过如下代码调用ChatGLM3-6B模型来生成对话:

from transformers import AutoTokenizer, AutoModel

tokenizer = AutoTokenizer.from_pretrained("THUDM/chatglm3-6b", trust_remote_code=True)

model = AutoModel.from_pretrained("THUDM/chatglm3-6b", trust_remote_code=True).half().cuda()

model = model.eval()

response, history = model.chat(tokenizer, "你好", history=[])

print(response)

response, history = model.chat(tokenizer, "晚上睡不着应该怎么办", history=history)

print(response)

参考文献:

[1]https://huggingface.co/THUDM/chatglm3-6b-base

[2]https://huggingface.co/THUDM/chatglm3-6b

[3]https://huggingface.co/THUDM/chatglm3-6b-32k

[4]低成本部署:https://github.com/THUDM/ChatGLM3/blob/main/DEPLOYMENT.md

[5]工具调用:https://github.com/THUDM/ChatGLM3/blob/main/tool_using/README.md

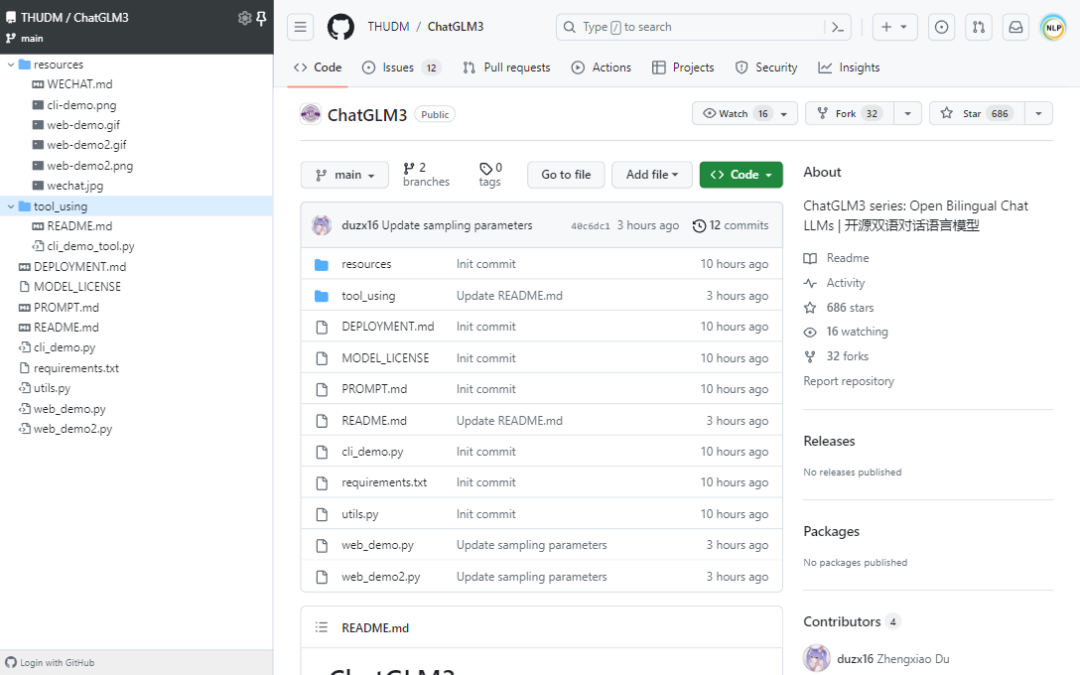

[6]https://github.com/THUDM/ChatGLM3