视频帧插值 (VFI) 是生成视频研究中的一个开放问题。挑战在于在视频序列中的两个现有帧之间生成中间帧。

从广义上讲,这种技术可以追溯到一个多世纪前,并从那时起一直用于传统动画中。在这种情况下,主“关键帧”将由首席动画艺术家生成,而“补间”中间帧的工作将由其他工作人员执行,这是一项更琐碎的任务。

在生成式 AI 兴起之前,帧插值被用于实时中间流估计 (RIFE)、深度感知视频帧插值 (DAIN) 和 Google 的大动作帧插值 (FILM – 见上文) 等项目,以提高现有视频的帧速率,或启用人工生成的慢动作效果。这是通过拆分剪辑的现有帧并生成估计的中间帧来实现的。

VFI 还用于开发更好的视频编解码器,更普遍地用于基于光流的系统(包括生成系统),这些系统利用即将到来的关键帧的先进知识来优化和塑造它们之前的间隙内容。

生成式视频系统中的结束帧

Luma 和 Kling 等现代生成系统允许用户指定开始帧和结束帧,并可以通过分析两个图像中的关键点并估计两个图像之间的轨迹来执行此任务。

正如我们在下面的示例中所看到的,提供“关闭”关键帧可以更好地让生成视频系统(在本例中为 Kling)保持身份等方面,即使结果并不完美(尤其是对于大型运动)。

Kling 是越来越多的视频生成器之一,包括 Runway 和 Luma,它们允许用户指定结束帧。在大多数情况下,最小的运动将导致最真实和最少缺陷的结果。来源: https://www.youtube.com/watch?v=8oylqODAaH8

在上面的示例中,人员的身份在两个用户提供的关键帧之间是一致的,从而导致视频生成相对一致。

在仅提供起始帧的情况下,生成系统的注意力窗口通常不够大,无法“记住”视频开始时的人是什么样子。相反,身份可能会随着每一帧而发生一点变化,直到所有相似性都消失。在下面的示例中,上传了起始图像,并且该人员的移动由文本提示引导:

由于没有结束帧,Kling 只有一小组紧接在前面的帧来指导下一帧的生成。在需要任何重大移动的情况下,这种身份的萎缩会变得严重。

我们可以看到,演员的相似性对指令没有弹性,因为生成系统不知道如果他微笑会是什么样子,而且他在种子图像中没有微笑(唯一可用的参考)。

大多数病毒式生成剪辑都经过精心策划,以淡化这些缺点。然而,时间一致的生成视频系统的进展可能取决于研究部门在帧插值方面的新发展,因为唯一可能的替代方案是依赖传统的 CGI 作为驱动的“引导”视频(即使在这种情况下,纹理和照明的一致性目前也很难实现)。

此外,从一小群最近的帧中派生新帧的缓慢迭代性质使得实现大型和大胆的动作变得非常困难。这是因为在帧中快速移动的对象可能会在单个帧的空间中从一侧移动到另一侧,这与系统可能已经训练的更平缓的运动相反。

同样,一个重大而大胆的姿势变化不仅可能导致身份转变,还可能导致生动的不一致:

在 Luma 的这个示例中,请求的移动似乎在训练数据中没有得到很好的表示。

成帧器

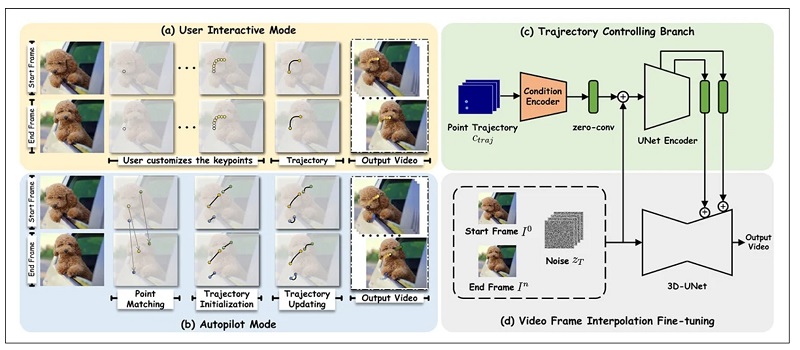

这让我们想到了最近来自中国的一篇有趣的论文,该论文声称在逼真的帧插值方面取得了新的进展——并且是同类论文中第一个提供基于拖动的用户交互的论文。

Framer 允许用户使用基于拖动的直观界面来指导运动,尽管它也具有“自动”模式。来源: https://www.youtube.com/watch?v=4MPGKgn7jRc

最近,以拖动为中心的应用程序在文献中变得很频繁,因为研究部门努力为生成系统提供工具,这些工具不是基于文本提示获得的相当粗糙的结果。

名为 Framer 的新系统不仅可以遵循用户引导的拖动,还可以具有更传统的“自动驾驶”模式。除了传统的补间外,该系统还能够生成延时模拟,以及输入图像的变形和新颖视图。

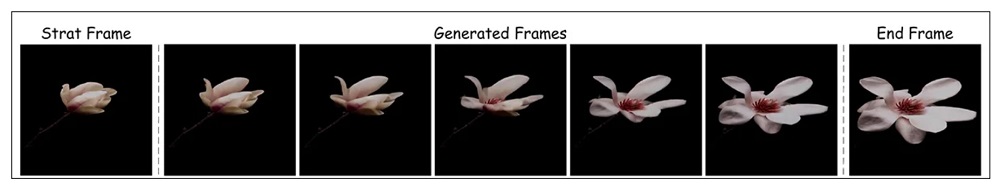

在 Framer 中为延时模拟生成的间隙帧。 来源: https://arxiv.org/pdf/2410.18978

在产生新颖的视图方面,Framer 稍微跨越了神经辐射场 (NeRF) 的领域——尽管只需要两个图像,而 NeRF 通常需要六个或更多图像输入视图。

在一项用户研究中,基于 Stability.ai 的 Stable Video Diffusion 潜在扩散生成视频模型构建的 Framer 能够胜过近似的竞争对手方法。

在撰写本文时,代码将在 GitHub 上发布。视频样本(上述图像来源于此)可在项目现场获得,研究人员还发布了一段 YouTube 视频。

这篇新论文名为《Framer: Interactive Frame Interpolation》,由浙江大学和阿里巴巴支持的蚂蚁集团的 9 名研究人员撰写。

方法

Framer 在其两种模式中的任何一种中使用基于关键点的插值,其中输入图像针对基本拓扑进行评估,并在必要时分配“可移动”点。实际上,这些点相当于基于 ID 的系统中的面部特征点,但泛化到任何表面。

研究人员在 OpenVid-1M 数据集上微调了稳定视频扩散 (SVD),增加了额外的最后一帧合成功能。这有助于建立轨迹控制机制(在下面架构图像的右上角),该机制可以评估朝向结束帧(或从结束帧返回)的路径。

Framer 的架构。

关于添加最后一帧条件,作者指出:

“为了尽可能保留预训练 SVD 的视觉先验,我们遵循 SVD 的条件反射范式,分别在潜在空间和语义空间注入端帧条件。

“具体来说,我们将第一帧 [帧] 的 VAE 编码的潜在特征与第一帧的噪声潜在特征连接起来,就像在 SVD 中所做的那样。此外,考虑到条件和相应的含噪潜在值在空间上是一致的,我们将最后一帧的潜在特征 zn 与结束帧的含噪潜在值连接起来。

“此外,我们分别提取第一帧和最后一帧的 CLIP 图像嵌入,并将它们连接起来以进行交叉注意力特征注入。”

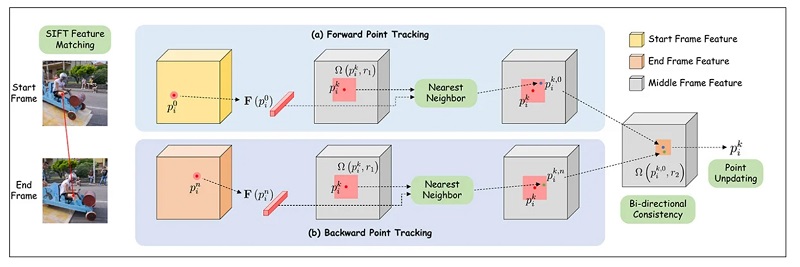

对于基于拖动的功能,轨迹模块利用了 Meta AI 主导的 CoTracker 框架,该框架评估了前方大量可能的路径。这些被精简到 1-10 个可能的轨迹之间。

然后,通过受 DragNUWA 和 DragAnything 架构启发的方法转换获得的点坐标。这将获得一个高斯热图,该热图将移动的目标区域个性化。

随后,数据被馈送到 ControlNet 的调节机制,ControlNet 是一个辅助的一致性系统,最初是为 Stable Diffusion 设计的,后来适应了其他架构。

对于自动驾驶模式,特征匹配最初是通过 SIFT 完成的,SIFT 解释轨迹,然后可以将其传递给受 DragGAN 和 DragDiffusion 启发的自动更新机制。

Framer 中点轨迹估计的模式。

数据和测试

对于 Framer 的微调,空间注意力和残差块被冻结,只有时间注意力层和残差块受到影响。

该模型在 AdamW 下进行了 10,000 次迭代训练,学习率为 1e-4,批量大小为 16。在 16 个 NVIDIA A100 GPU 上进行训练。

由于之前解决问题的方法不提供基于拖动的编辑,因此研究人员选择将 Framer 的自动驾驶模式与旧产品的标准功能进行比较。

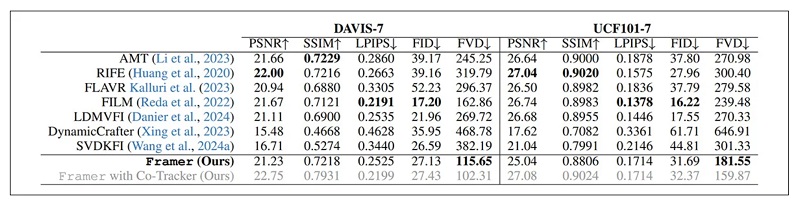

针对当前基于扩散的视频生成系统类别测试的框架是 LDMVFI;动态工匠;和 SVDKFI。对于“传统”视频系统,竞争对手框架是 AMT;RIFE;弗拉夫;和前面提到的 FILM。

除了用户研究外,还对 DAVIS 和 UCF101 数据集进行了测试。

定性测试只能由研究团队的客观部门和用户研究进行评估。然而,论文指出,传统的定量指标在很大程度上并不适合手头的主张:

“PSNR、SSIM 和 LPIPS 等 [重建] 指标无法准确捕捉插值帧的质量,因为它们会损害其他与原始视频像素不对齐的合理插值结果。

“虽然 FID 等生成指标提供了一些改进,但它们仍然不足,因为它们没有考虑时间一致性并孤立地评估帧。”

尽管如此,研究人员还是使用几个流行的指标进行了定性测试:

Framer 与竞争对手系统的定量结果。

作者指出,尽管赔率对他们不利,但 Framer 仍然在测试的方法中取得了最好的 FVD 分数。

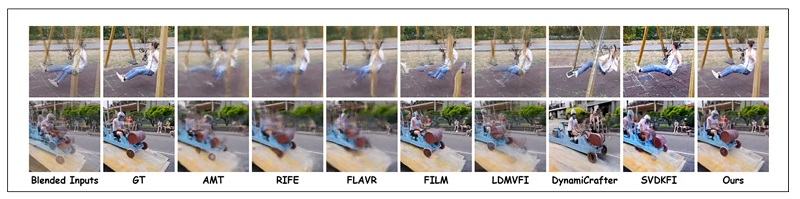

以下是该论文的定性比较样本结果:

与以前的方法进行定性比较。请参阅论文以获得更好的分辨率,以及 https://www.youtube.com/watch?v=4MPGKgn7jRc 上的视频结果。

作者评论道:

“与现有的插值技术相比,[我们的] 方法可以产生明显更清晰的纹理和自然的运动。它在输入帧之间存在很大差异的场景中表现尤其出色,因为传统方法通常无法准确插入内容。

“与 LDMVFI 和 SVDKFI 等其他基于扩散的方法相比,Framer 对具有挑战性的情况表现出卓越的适应性,并提供更好的控制。”

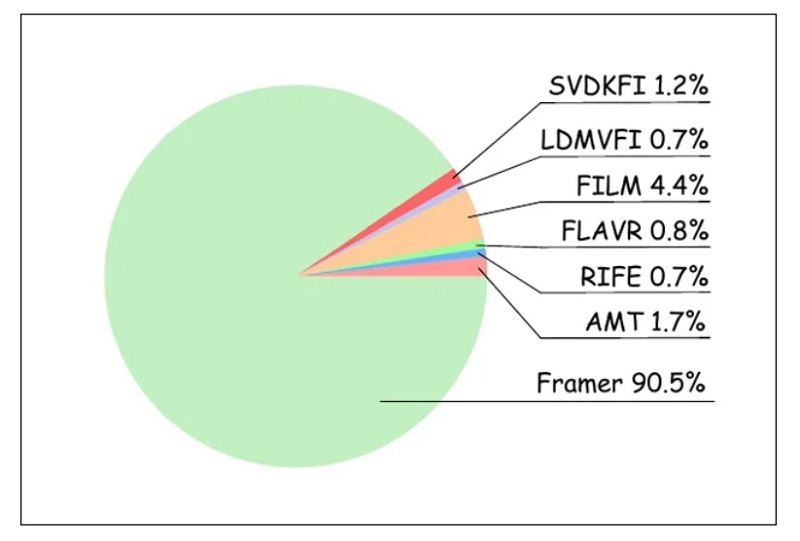

对于用户研究,研究人员收集了 20 名参与者,他们评估了来自各种测试方法的 100 个随机排序的视频结果。因此,获得了 1000 个评分,评估了最“现实”的产品:

用户研究的结果。

从上图可以看出,用户压倒性地喜欢 Framer 的结果。

该项目随附的 YouTube 视频概述了 framer 的一些潜在其他用途,包括变形和卡通中间——整个概念就是从这里开始的。

结论

很难过分强调这一挑战目前对于基于 AI 的视频生成任务的重要性。迄今为止,业余和专业社区都已使用 FILM 和(非 AI)EbSynth 等较旧的解决方案在帧之间进行补间;但这些解决方案有明显的局限性。

由于新 T2V 框架的官方示例视频的虚伪策划,公众普遍存在一种误解,即机器学习系统可以准确推断运动中的几何图形,而无需求助于指导机制(如 3D 可变形模型 (3DMM))或其他辅助方法(如 LoRA)。

老实说,补间本身,即使它可以完美地执行,也只构成了对这个问题的 “黑客 ”或欺骗。尽管如此,由于生成两个对齐良好的帧图像通常比通过文本提示或当前一系列替代方案进行指导更容易,因此很高兴看到这种旧方法的基于 AI 的版本的迭代进展。